Operating System ตอน : ปฏิบัติการบริหารระบบ แบบคบซ้ำซ้อน

ระบบปฏิบัติการ (Operating System: OS) คือซอฟต์แวร์ที่ทำหน้าที่เป็นตัวกลางในการจัดการและควบคุมการทำงานของฮาร์ดแวร์ของระบบสมองกลและการทำงานของโปรแกรมหรือแอปพลิเคชันต่างๆ ที่ผู้ใช้ต้องการใช้งาน ระบบปฏิบัติการจะเชื่อมโยงการทำงานระหว่างส่วนประกอบของระบบสมองกล เช่น หน่วยประมวลผลกลาง (CPU), หน่วยความจำ (RAM), อุปกรณ์จัดเก็บข้อมูล (Storage), และอุปกรณ์อินพุต/เอาท์พุต (Input/Output devices) โดยทำให้ซอฟต์แวร์หรือแอปพลิเคชันสามารถใช้งานฮาร์ดแวร์ได้อย่างราบรื่นและมีประสิทธิภาพ

ระบบปฏิบัติการเป็นสิ่งที่จำเป็นในการทำให้ระบบสมองกลสามารถทำงานได้ตามปกติ หากไม่มีระบบปฏิบัติการ ระบบสมองกลจะไม่สามารถใช้งานได้อย่างเต็มที่ เพราะไม่มีซอฟต์แวร์ที่ควบคุมการทำงานของฮาร์ดแวร์และจัดสรรทรัพยากรต่างๆ ให้กับแอปพลิเคชันที่ผู้ใช้ต้องการใช้งาน โดยไม่มี OS ผู้ใช้ต้องเขียนโปรแกรมหรือโค้ดเพื่อควบคุมฮาร์ดแวร์ทุกส่วนด้วยตัวเอง ซึ่งเป็นเรื่องที่ซับซ้อนและต้องใช้เวลาในการพัฒนาอย่างมาก

หากไม่มีระบบปฏิบัติการ การจัดการทรัพยากรของระบบสมองกลจะเป็นไปอย่างไม่มีระเบียบ ผู้ใช้จะไม่สามารถทำงานหลายโปรแกรมพร้อมกันได้ (Multitasking) และการทำงานพื้นฐานต่างๆ เช่น การจัดการไฟล์, การควบคุมอุปกรณ์อินพุตและเอาท์พุต, การเชื่อมต่อกับเครือข่าย, หรือแม้แต่การรักษาความปลอดภัยของข้อมูลจะกลายเป็นเรื่องที่ยากและไม่มีประสิทธิภาพ การจัดการการทำงานหลายๆ งานพร้อมกัน เช่น เปิดเว็บเบราว์เซอร์ ฟังเพลง และเขียนเอกสาร จะไม่สามารถทำได้ และแต่ละงานต้องดำเนินการทีละอย่าง ซึ่งจะทำให้การใช้งานระบบสมองกลช้าลง

โดยรวมแล้ว ระบบปฏิบัติการทำให้ระบบสมองกลสามารถทำงานได้อย่างมีระเบียบ, ช่วยให้การใช้งานง่ายขึ้น และทำให้การพัฒนาแอปพลิเคชันทำได้รวดเร็วและมีประสิทธิภาพ หากไม่มี OS การใช้งานระบบสมองกลจะกลายเป็นเรื่องยุ่งยากและซับซ้อนขึ้นมาก ซึ่งจะลดประสิทธิภาพในการทำงานและการพัฒนาต่างๆ อย่างมาก

ก่อนที่ระบบปฏิบัติการจะมีบทบาทสำคัญในการควบคุมการทำงานของคอมพิวเตอร์หรือระบบสมองกล ซอฟต์แวร์ในยุคแรกๆ มีลักษณะเป็นโปรแกรมที่เขียนขึ้นเพื่อทำงานเฉพาะด้านและมักจะต้องทำงานโดยตรงกับฮาร์ดแวร์ ซึ่งแตกต่างจากซอฟต์แวร์ในปัจจุบันที่ทำงานภายใต้การจัดการของระบบปฏิบัติการ

ในยุคก่อนที่ระบบปฏิบัติการจะถูกพัฒนา การทำงานของซอฟต์แวร์มักจะเป็นโปรแกรมที่เขียนขึ้นให้ทำงานเพียงแค่ฟังก์ชันเดียวหรือชุดคำสั่งที่จำกัด เช่น โปรแกรมคำนวณหรือเกมบางประเภท โปรแกรมเหล่านี้ต้องทำงานโดยตรงกับฮาร์ดแวร์ของเครื่องคอมพิวเตอร์ ซึ่งผู้ใช้หรือโปรแกรมเมอร์จะต้องทำการตั้งค่าหรือสั่งการให้เครื่องทำงานทุกครั้ง เช่น การเข้าถึงหน่วยความจำ, การควบคุมอุปกรณ์อินพุต/เอาท์พุต, การควบคุมการประมวลผล โดยที่ไม่มีการช่วยเหลือจากระบบปฏิบัติการ

หนึ่งในลักษณะสำคัญของซอฟต์แวร์ในยุคก่อนระบบปฏิบัติการคือการขาดการจัดการทรัพยากรที่มีประสิทธิภาพ ซึ่งหมายความว่า โปรแกรมหนึ่งสามารถใช้ทรัพยากรของคอมพิวเตอร์ทั้งหมดได้โดยไม่มีการแบ่งปัน หรือในบางกรณี เครื่องคอมพิวเตอร์อาจจะทำงานได้เพียงแค่หนึ่งโปรแกรมในแต่ละครั้ง (Monoprogramming) ซึ่งทำให้การใช้ประโยชน์จากคอมพิวเตอร์ไม่เต็มประสิทธิภาพ

เมื่อเทคโนโลยีและความซับซ้อนของคอมพิวเตอร์เพิ่มขึ้น การพัฒนาระบบปฏิบัติการเริ่มเกิดขึ้น เพื่อจัดการการใช้ทรัพยากรและช่วยให้สามารถรันโปรแกรมหลายๆ ตัวพร้อมกันได้ (Multitasking) การจัดการการเข้าถึงฮาร์ดแวร์และอุปกรณ์ต่างๆ ได้ง่ายขึ้น และสามารถให้บริการต่างๆ เช่น การจัดการไฟล์, การรักษาความปลอดภัย, การสื่อสารกับผู้ใช้ และอื่นๆ ผ่านหน้าจอและอินเตอร์เฟซที่ใช้งานง่าย

ดังนั้น ในยุคก่อนระบบปฏิบัติการ ซอฟต์แวร์จะมีลักษณะเป็นโปรแกรมเฉพาะที่ทำงานเพียงแค่ฟังก์ชันเดียวและต้องทำงานโดยตรงกับฮาร์ดแวร์ ขาดการจัดการทรัพยากรที่มีประสิทธิภาพและไม่สามารถทำงานหลายโปรแกรมพร้อมกันได้ ทำให้การพัฒนาและการใช้งานคอมพิวเตอร์ยังมีข้อจำกัดมาก เมื่อระบบปฏิบัติการเกิดขึ้น การใช้งานคอมพิวเตอร์ได้พัฒนาไปสู่การทำงานที่มีประสิทธิภาพและสะดวกสบายยิ่งขึ้น

Concurrent Execution : ทำหลายอย่างพร้อม ๆ กัน

Concurrent Execution หมายถึงความสามารถของระบบในการจัดการหลายงาน (Tasks) หรือกระบวนการ (Processes) ให้ดำเนินการในเวลาเดียวกัน หรือในช่วงเวลาที่ทับซ้อนกัน โดยไม่จำเป็นว่าต้องดำเนินการพร้อมกันจริง ๆ บน CPU หลายตัว (ซึ่งเรียกว่า Parallel Execution)

ในการทำงานแบบ Concurrent Execution ระบบจะสลับการใช้งานทรัพยากรที่มีอยู่ เช่น CPU หรือหน่วยความจำ ระหว่างงานต่าง ๆ อย่างรวดเร็ว เพื่อให้หลายโปรแกรมหรือหลายงานในโปรแกรมเดียวดูเหมือนทำงานพร้อมกัน แม้ว่าจริง ๆ แล้ว CPU จะประมวลผลทีละงานในช่วงเวลาใดเวลาหนึ่งเท่านั้น

โดยปกติแล้วระบบจะใช้เทคนิคต่าง ๆ เพื่อสร้างความรู้สึกที่ว่า “หลายงานกำลังทำงานพร้อมกัน” เช่น

🚩 Time Sharing

หรือ การแบ่งเวลาของ CPU เป็นเทคนิคที่ใช้ในการจัดสรรทรัพยากร CPU ให้กับงานหลายๆ ตัวที่ต้องการประมวลผลในช่วงเวลาเดียวกัน โดยที่ระบบจะสลับการทำงานระหว่างงานต่างๆ (Process หรือ Thread) ในแต่ละช่วงเวลาเล็กๆ ซึ่งช่วยให้ดูเหมือนว่าทุกงานทำงานพร้อมกัน แม้ในความเป็นจริงแล้วมันทำงานทีละงานในช่วงเวลาสั้นๆ เท่านั้น

พื้นฐานทำงานของ Time Sharing

◘ Context Switching เป็นกระบวนการที่สำคัญในระบบปฏิบัติการที่ช่วยให้สามารถจัดการและควบคุมการทำงานของหลาย Tasks ได้อย่างมีประสิทธิภาพ โดยระบบจะทำการสลับการทำงานระหว่าง Tasks ต่าง ๆ ด้วยการเก็บและโหลดสถานะของแต่ละ Task ในแต่ละครั้ง เพื่อให้ทุก Task มีโอกาสได้รับการประมวลผลอย่างเท่าเทียม กระบวนการนี้มีบทบาทสำคัญในระบบที่ใช้ Time Sharing ซึ่งจัดสรรเวลาให้แต่ละ Task ทำงานในช่วงเวลาสั้น ๆ สลับกันไป หรือในกรณีที่ระบบต้องจัดการงานหลายอย่างพร้อมกัน (Concurrent Execution) โดยไม่ปล่อยให้ Task ใดได้รับการประมวลผลมากเกินไป

การเก็บและโหลด Context ในแต่ละรอบจะครอบคลุมข้อมูลสำคัญ เช่น การตั้งค่า CPU Registers, ตำแหน่งหน่วยความจำ, สถานะตัวแปรภายใน Task, ตัวชี้หน่วยความจำ, การตั้งค่า Flags, และข้อมูลเกี่ยวกับอุปกรณ์ I/O ที่เกี่ยวข้อง กระบวนการนี้ช่วยให้ระบบสามารถหยุดงานหนึ่งชั่วคราว เก็บสถานะทั้งหมดไว้ จากนั้นสลับไปประมวลผล Task อื่นได้ เมื่อถึงเวลาที่ Task แรกจะต้องกลับมาทำงาน ระบบจะโหลดสถานะของมันกลับมา เพื่อให้ทำงานต่อได้จากจุดที่หยุดไว้

แม้ว่าการสลับ Context จะเกิดขึ้นในระดับมิลลิวินาที แต่ความเร็วของกระบวนการทำให้ดูเหมือนว่า Tasks ทุกงานกำลังทำงานพร้อมกัน (Concurrency) ทั้งที่จริง ๆ แล้วระบบประมวลผลเพียงหนึ่ง Task ในแต่ละช่วงเวลา การทำงานของ Context Switching ยังช่วยให้ระบบปฏิบัติการสามารถบริหารจัดการงานต่าง ๆ ได้ทั้งในระบบที่มี CPU เดียวหรือหลายคอร์ โดยสามารถสลับการทำงานระหว่างคอร์ต่าง ๆ ได้อย่างราบรื่นและมีประสิทธิภาพ

◘ Time Slice เป็นแนวคิดที่เกี่ยวข้องกับการจัดการทรัพยากร CPU ในระบบปฏิบัติการที่ใช้เทคนิค Time Sharing เพื่อให้ระบบสามารถทำงานกับหลายๆ งาน (Tasks) ได้ในลักษณะเดียวกัน แม้ว่าจะมีการใช้ CPU เพียงตัวเดียวก็ตาม โดยในแต่ละช่วงเวลาที่ CPU จัดสรรให้กับงานหนึ่งๆ จะเรียกว่า Time Slice ช่วงเวลานี้จะค่อนข้างสั้นเพื่อให้งานต่างๆ ได้มีโอกาสทำงานอย่างเท่าเทียมกัน Time Slice มักมีระยะเวลาเพียงไม่กี่มิลลิวินาทีถึงไม่กี่ร้อยมิลลิวินาที ขึ้นอยู่กับการตั้งค่าของระบบปฏิบัติการหรือโปรเซสเซอร์

หากงานยังไม่เสร็จสมบูรณ์ในช่วงเวลานั้น ระบบจะหยุดการทำงานของงานนั้น และสลับไปทำงานของงานอื่นแทน เพื่อให้งานอื่นๆ ได้มีโอกาสใช้งาน CPU เมื่อถึงเวลาที่กำหนดอีกครั้ง งานที่ถูกหยุดไว้ก่อนหน้านี้จะกลับมาทำงานต่อจากจุดที่มันหยุดไป (หรือจาก Context ที่ถูกเก็บไว้ก่อนการสลับ) กระบวนการนี้จะเกิดขึ้นอย่างรวดเร็วและบ่อยครั้ง ซึ่งช่วยให้ผู้ใช้รู้สึกว่าโปรแกรมต่างๆ ทำงานพร้อมกัน แม้ว่าจริงๆ แล้วระบบจะสลับการทำงานระหว่างงานต่างๆ ไปมาอย่างรวดเร็ว

การแบ่งเวลาแบบนี้ช่วยให้ระบบสามารถทำงานหลายงานได้พร้อมกันโดยไม่จำเป็นต้องรอให้งานใดงานหนึ่งทำงานเสร็จสิ้นทั้งหมด ระบบจึงสามารถจัดสรรทรัพยากรได้อย่างมีประสิทธิภาพ โดยไม่ทำให้ผู้ใช้รู้สึกถึงการหน่วงหรือการรอคอย เพราะงานทุกงานได้รับโอกาสในการทำงานในระยะเวลาที่ใกล้เคียงกันอย่างยุติธรรม ระบบที่มีหลายงานทำงานพร้อมกันในลักษณะนี้จะช่วยให้การทำงานเป็นแบบ Concurrent Execution โดยไม่จำเป็นต้องรอให้งานใดๆ เสร็จสิ้นก่อน ระบบสามารถประมวลผลงานหลายๆ งานได้ในเวลาเดียวกันผ่านการสลับการทำงานอย่างรวดเร็วและมีประสิทธิภาพ

◘ การสลับระหว่างงาน (Context Switch Timing) เป็นกระบวนการสำคัญในระบบปฏิบัติการที่ใช้เทคนิค Time Sharing เพื่อรองรับการทำงานของหลายๆ งานพร้อมกันอย่างมีประสิทธิภาพ โดยระบบจะจัดสรรเวลา CPU ให้กับแต่ละงานตามลำดับ กระบวนการสลับนี้ทำให้ผู้ใช้รู้สึกว่าโปรแกรมต่างๆ สามารถทำงานพร้อมกันได้ ทั้งที่ในความเป็นจริง ระบบกำลังสลับการทำงานระหว่างงานเหล่านั้นอย่างรวดเร็วในช่วงเวลาที่กำหนด

ตัวอย่างของการสลับระหว่างงาน เช่น เมื่อโปรแกรมหนึ่งกำลังคำนวณข้อมูลแต่ต้องรอการรับข้อมูลจากอุปกรณ์ I/O (เช่น การอ่านข้อมูลจากดิสก์) ระบบสามารถสลับไปทำงานกับโปรแกรมอื่น เช่น โปรแกรมแชทหรือโปรแกรมฟังเพลง ซึ่งไม่ต้องรอข้อมูลจาก I/O วิธีนี้ช่วยให้ CPU ถูกใช้งานอย่างคุ้มค่า โดยไม่ปล่อยให้ว่างเปล่าระหว่างที่โปรแกรมกำลังรอ

Time Slice หรือ Quantum คือช่วงเวลาที่ระบบปฏิบัติการจัดสรรให้แต่ละงานได้ทำงาน ช่วงเวลานี้มักถูกกำหนดให้สั้นเพียงไม่กี่มิลลิวินาทีถึงไม่กี่ร้อยมิลลิวินาที ทั้งนี้ขึ้นอยู่กับการตั้งค่าของระบบปฏิบัติการ หากงานหนึ่งยังไม่เสร็จในช่วง Time Slice ที่กำหนด ระบบจะหยุดงานนั้นชั่วคราว และสลับไปทำงานกับงานอื่นในระบบ เมื่อถึงลำดับของงานเดิมอีกครั้ง งานนั้นจะได้โอกาสทำงานต่อจากจุดที่ค้างไว้

ในบางกรณี ระบบอาจปรับระยะเวลา Time Slice ให้เหมาะสมกับลักษณะของงานหรือความต้องการเฉพาะของโปรแกรม ตัวอย่างเช่น หากโปรแกรมหนึ่งมีการคำนวณซับซ้อนและต้องการเวลาที่ยาวขึ้น ระบบอาจขยายระยะเวลา Time Slice เพื่อให้โปรแกรมสามารถทำงานได้อย่างต่อเนื่องและไม่ถูกสลับบ่อยเกินไป การปรับระยะเวลาเหล่านี้มีความสำคัญในการเพิ่มประสิทธิภาพการทำงานของระบบโดยรวม

การสลับระหว่างงานอัตโนมัติในลักษณะนี้ ช่วยรักษาความยุติธรรมในการแบ่งทรัพยากร CPU ให้กับโปรแกรมทุกตัว ระบบปฏิบัติการจึงสามารถจัดการงานหลายงานพร้อมกันได้อย่างมีประสิทธิภาพและราบรื่น ขณะเดียวกันยังรักษาประสิทธิภาพโดยรวมของระบบ และมอบประสบการณ์ที่ดีให้กับผู้ใช้

🚩 Asynchronous Execution

การทำงานแบบอะซิงโครนัส (Asynchronous Execution) เป็นวิธีการที่ช่วยให้ระบบสามารถเริ่มต้นและดำเนินการหลายงานพร้อมกันโดยไม่ต้องรอให้กระบวนการใดเสร็จสิ้นก่อน ซึ่งแตกต่างจากการทำงานแบบซิงโครนัส (Synchronous Execution) ที่จะต้องทำงานตามลำดับขั้นตอน โดยงานหนึ่งต้องเสร็จก่อนถึงจะเริ่มงานถัดไป การทำงานแบบอะซิงโครนัสจึงช่วยให้ระบบสามารถทำงานหลายๆ งานพร้อมกันได้ โดยไม่ต้องรอให้กระบวนการอื่นๆ เสร็จสิ้น

เทคนิคนี้มีความสำคัญอย่างยิ่งในกระบวนการที่เกี่ยวข้องกับการรับส่งข้อมูลหรือการประมวลผล I/O (Input/Output) ซึ่งมักจะมีการรอคอยระหว่างการติดต่อกับอุปกรณ์ภายนอก เช่น การดึงข้อมูลจากฐานข้อมูล การส่งคำขอไปยังเซิร์ฟเวอร์ หรือการอ่าน/เขียนไฟล์ เมื่อระบบกำลังรอข้อมูลจากแหล่งภายนอก ระบบสามารถทำงานกับงานอื่นๆ ที่ไม่ต้องรอผลลัพธ์ได้ ทำให้ใช้ทรัพยากรได้อย่างมีประสิทธิภาพมากขึ้น

ตัวอย่างการใช้งานของการทำงานแบบอะซิงโครนัส ได้แก่ การรอข้อมูลจากเซิร์ฟเวอร์ ในขณะที่รอระบบยังสามารถทำงานกับงานอื่นๆ ได้ เช่น การประมวลผลคำสั่งที่ไม่ต้องการการรอคอย สิ่งนี้ทำให้สามารถลดเวลาการรอคอยที่ไม่จำเป็นและเพิ่มประสิทธิภาพในการจัดการหลายงานพร้อมกันได้ การทำงานแบบอะซิงโครนัสยังช่วยให้โปรแกรมทำงานได้อย่างราบรื่นโดยไม่เกิดการหยุดชะงัก (non-blocking) เนื่องจากงานที่ต้องรอการตอบกลับจะไม่ขัดขวางกระบวนการอื่นๆ ที่สามารถทำงานได้ในระหว่างนั้น

การทำงานแบบอะซิงโครนัสได้รับการนำไปใช้ในหลายๆ แอปพลิเคชัน เช่น เว็บเซิร์ฟเวอร์ ระบบเครือข่าย หรือแอปพลิเคชันที่ต้องการประมวลผลข้อมูลจำนวนมากอย่างมีประสิทธิภาพ โดยสามารถจัดการเวลาและทรัพยากรได้ดี โดยไม่บล็อกการทำงานของโปรแกรมส่วนอื่นๆ แม้ว่าจะมีการรอผลจากแหล่งข้อมูลภายนอก

ในระบบปฏิบัติการ (OS) การทำงานแบบอะซิงโครนัสมีบทบาทสำคัญในการจัดการหลายกระบวนการพร้อมกัน โดยที่การทำงานของระบบไม่ถูกบล็อกหรือหยุดชะงัก เนื่องจาก OS ต้องจัดการการประมวลผลที่เกิดขึ้นพร้อมกันในหลายๆ ส่วน เช่น การรับส่งข้อมูล การทำงานของโปรแกรมต่างๆ หรือการตอบสนองจากผู้ใช้ การทำงานแบบอะซิงโครนัสใน OS สามารถใช้เทคนิคต่างๆ เช่น การใช้คิวของงานที่รอการดำเนินการ การใช้สัญญาณหรือการแจ้งเตือนเมื่อการทำงานบางอย่างเสร็จสิ้น หรือการใช้การทำงานแบบไม่บล็อก (non-blocking) เพื่อให้ OS สามารถจัดการกับหลายงานได้พร้อมกัน เช่น การจัดการกับ I/O การสื่อสารกับอุปกรณ์ภายนอก หรือการเชื่อมต่อกับเครือข่าย โดยที่กระบวนการอื่นๆ สามารถทำงานได้ในขณะรอผลลัพธ์จากงานเหล่านั้น

ในระบบปฏิบัติการที่ทันสมัย เช่น Linux หรือ Windows การทำงานแบบอะซิงโครนัสมักถูกใช้ในการจัดการกับกระบวนการที่ต้องการการรอคอยหรือการตอบกลับจากแหล่งข้อมูลภายนอก เช่น การส่งคำขอ HTTP หรือการสื่อสารกับเซิร์ฟเวอร์ นอกจากนี้ การทำงานแบบอะซิงโครนัสในระบบที่รองรับการทำงานแบบมัลติทาสก์ (Multitasking) ช่วยให้ OS สามารถจัดการกระบวนการหลายๆ อย่างได้อย่างราบรื่น โดยไม่ต้องหยุดกระบวนการอื่นๆ ขณะรอการตอบกลับจากภายนอก

นอกจากนี้ OS ยังใช้การทำงานแบบอะซิงโครนัสในการจัดการกับเหตุการณ์จากผู้ใช้ เช่น การคลิกเมาส์หรือการสัมผัสหน้าจอ ซึ่งต้องการการประมวลผลทันทีเพื่อให้ตอบสนองต่อผู้ใช้ได้อย่างรวดเร็ว โดยไม่ต้องรอการประมวลผลงานอื่นๆ

ในกระบวนการของเครือข่าย (Networking) การทำงานแบบอะซิงโครนัสใน OS ช่วยให้ระบบสามารถส่งและรับข้อมูลจากเครือข่ายได้อย่างมีประสิทธิภาพ ขณะที่กระบวนการอื่นๆ ยังทำงานได้พร้อมกัน เช่น การจัดการคำขอของผู้ใช้หรือกระบวนการที่เกี่ยวข้องกับฐานข้อมูล โดยไม่ต้องรอให้การรับส่งข้อมูลเสร็จสิ้นก่อน

สรุปได้ว่า การทำงานแบบอะซิงโครนัสใน OS ช่วยให้การจัดการหลายกระบวนการทำได้พร้อมกันและมีประสิทธิภาพ โดยไม่บล็อกกระบวนการอื่นๆ ช่วยให้ระบบสามารถประมวลผลต่างๆ ได้ราบรื่นและมีประสิทธิภาพสูงสุด

🚩 Parallelism หรือ การประมวลผลพร้อมกัน

Parallelism เป็นการขยายแนวคิดจากการทำงานแบบ Concurrent Execution ที่สามารถทำให้หลายงานทำงานในช่วงเวลาที่ทับซ้อนกัน โดยการใช้หลายหน่วยประมวลผล (CPU หรือหลายคอร์) เพื่อดำเนินการงานหลาย ๆ งานในเวลาเดียวกันจริง ๆ ซึ่งจะช่วยเพิ่มประสิทธิภาพในการทำงานที่ต้องการการประมวลผลหนักหรือต้องการการดำเนินการที่รวดเร็ว

ในสภาพแวดล้อมของการประมวลผลแบบ Parallel Execution ระบบจะสามารถแบ่งงานออกเป็นหลายส่วนย่อย ๆ และมอบหมายให้แต่ละหน่วยประมวลผล (เช่น คอร์ของ CPU หรือเครื่องจักรหลายตัว) ดำเนินการในแต่ละส่วนของงานนั้นพร้อมกัน การประมวลผลแบบนี้สามารถเพิ่มความเร็วในการทำงานได้อย่างมาก เนื่องจากสามารถใช้พลังการประมวลผลทั้งหมดที่มีในระบบได้อย่างเต็มที่

ตัวอย่างของการใช้ Parallelism ได้แก่ การประมวลผลข้อมูลในลักษณะ data parallelism ซึ่งข้อมูลชุดใหญ่จะถูกแบ่งออกเป็นส่วน ๆ และส่งไปยังคอร์หรือเครื่องจักรต่าง ๆ เพื่อให้ประมวลผลพร้อมกัน โดยเฉพาะในกรณีของการคำนวณทางวิทยาศาสตร์ การประมวลผลภาพ หรือการวิเคราะห์ข้อมูลที่ซับซ้อน การประมวลผลแบบพร้อมกันทำให้สามารถจัดการกับข้อมูลจำนวนมากได้ในเวลาอันรวดเร็ว ซึ่งช่วยให้ผลลัพธ์สามารถถูกสร้างขึ้นได้เร็วขึ้นและมีประสิทธิภาพสูงขึ้น

การประมวลผลแบบ Parallel มีข้อดีหลายประการ โดยเฉพาะเมื่อทำงานกับโปรแกรมที่ต้องการการคำนวณที่มากมายหรือที่ใช้เวลาในการประมวลผลยาวนาน การประมวลผลในลักษณะนี้สามารถแบ่งงานย่อย ๆ ออกไปให้กับแต่ละคอร์ใน CPU หรือเครื่องคอมพิวเตอร์หลายตัว ทำให้สามารถทำงานได้หลายงานพร้อมกันและลดระยะเวลาการทำงานรวมทั้งหมด

อย่างไรก็ตาม การประมวลผลแบบ Parallel ยังมีข้อจำกัดและความท้าทายในการออกแบบ เช่น การแบ่งงานให้มีความสมดุลและไม่เกิดปัญหาของการขัดแย้งในการเข้าถึงข้อมูลหรือการซิงโครไนซ์ระหว่างการทำงานของคอร์หลายตัว ซึ่งอาจทำให้ประสิทธิภาพที่คาดหวังไม่เป็นไปตามที่ต้องการหากไม่ออกแบบระบบให้ดี

โดยสรุป การประมวลผลแบบ Parallelism ช่วยให้สามารถใช้ประโยชน์จากหลาย CPU หรือหลายคอร์ในกระบวนการทำงานพร้อมกันจริง ๆ ทำให้สามารถเพิ่มประสิทธิภาพในการประมวลผลได้อย่างมาก โดยเฉพาะในงานที่ต้องการความเร็วหรือประสิทธิภาพในการจัดการข้อมูลขนาดใหญ่

การทำงานแบบ concurrent execution ในระบบปฏิบัติการ

concurrent execution ในระบบปฏิบัติการหมายถึงการที่ระบบสามารถจัดการหลายกระบวนการหรือหลายงานในเวลาเดียวกัน แม้ว่าจะมีทรัพยากรเครื่องคอมพิวเตอร์ที่จำกัด การทำงานแบบนี้เป็นการทำงานพร้อมกันโดยที่งานต่างๆ ไม่จำเป็นต้องทำงานเสร็จสิ้นพร้อมกันทั้งหมด แต่ระบบสามารถสลับไปมาระหว่างงานต่างๆ ได้ ซึ่งช่วยให้สามารถใช้ทรัพยากรได้อย่างมีประสิทธิภาพสูงสุด ในเชิงแนวคิดของ OS การทำงาน concurrent execution สามารถแบ่งงานใหญ่ๆ ที่ซับซ้อนออกเป็นงานย่อยๆ ที่เรียกว่า tasks หรือ threads ซึ่งแต่ละงานย่อยสามารถทำงานได้อย่างอิสระหรือพร้อมกันโดยไม่ต้องรอให้กระบวนการใดกระบวนการหนึ่งเสร็จสิ้นก่อน งานย่อยเหล่านี้อาจจะทำงานในลำดับที่แตกต่างกันไป หรืออาจทำงานพร้อมกันในบางส่วนของโปรแกรมขึ้นอยู่กับวิธีที่ OS จัดการกับการทำงานเหล่านั้น การแบ่งงานใหญ่เป็นงานย่อยๆ มีประโยชน์หลายอย่าง โดยเฉพาะในการจัดการกับงานที่ต้องใช้เวลาในการประมวลผล เช่น การรอข้อมูลจากภายนอก หรือการทำงานที่เกี่ยวกับ I/O (Input/Output) ซึ่งงานย่อยๆ จะทำให้ OS สามารถจัดการกับงานอื่นๆ ได้ในระหว่างที่กำลังรอผลลัพธ์จากงานหลัก ตัวอย่างเช่น เมื่อระบบต้องรอข้อมูลจากเซิร์ฟเวอร์ ในขณะที่รอระบบสามารถทำงานกับงานอื่นๆ ได้ เช่น การประมวลผลคำสั่งจากผู้ใช้ การแบ่งงานออกเป็นงานย่อยๆ ยังช่วยให้การทำงานแบบ concurrent execution สามารถทำงานได้อย่างราบรื่นในระบบที่รองรับการทำงานหลายงานพร้อมกัน เช่น ระบบที่รองรับมัลติทาสก์ (Multitasking) โดยไม่ให้ระบบหยุดทำงานเมื่อกระบวนการใดกระบวนการหนึ่งกำลังรอข้อมูลหรือผลลัพธ์จากการทำงานอื่น การทำเช่นนี้ช่วยลดการบล็อกการทำงานของระบบ (Non-blocking) และยังช่วยเพิ่มประสิทธิภาพในการประมวลผลงานที่มีลักษณะต้องรอการตอบกลับจากแหล่งข้อมูลภายนอก เช่น การอ่าน/เขียนข้อมูลจากไฟล์ หรือการสื่อสารผ่านเครือข่าย การแบ่งงานออกเป็นงานย่อยๆ ใน OS ยังช่วยให้สามารถใช้ทรัพยากรอย่างมีประสิทธิภาพโดยไม่ให้เกิดการแออัดของกระบวนการต่างๆ ที่ต้องรอคอย เช่น การแบ่งงานเป็นหลายๆ thread หรือโปรเซส ที่สามารถทำงานได้พร้อมกัน โดยการใช้การจัดการเวลาและทรัพยากรที่เหมาะสม เช่น การจัดการด้วยคิว หรือการใช้ตัวช่วยในการแจ้งเตือน เมื่อกระบวนการหรือ task เสร็จสิ้นและสามารถดำเนินการกับงานถัดไปได้ โดยสรุป การทำงานแบบ concurrent execution ของ OS ที่แบ่งงานเป็นงานย่อยๆ ทำให้ระบบสามารถจัดการกับหลายงานพร้อมกันได้อย่างมีประสิทธิภาพ ช่วยลดการรอคอย และเพิ่มประสิทธิภาพในการใช้ทรัพยากรของระบบ โดยไม่เกิดการบล็อกหรือหยุดชะงักในการทำงานของกระบวนการอื่น ๆ

ส่วนประกอบของระบบปฏิบัติการ

ส่วนประกอบหลักของระบบปฏิบัติการ ที่ทำงานร่วมกันเพื่อจัดการและควบคุมการทำงานของคอมพิวเตอร์หรือระบบสมองกล ซึ่งทำให้สามารถใช้งานแอปพลิเคชันต่างๆ ได้อย่างมีประสิทธิภาพ ส่วนประกอบหลักของระบบปฏิบัติการมีดังนี้:

⦿ ส่วนแก่นกลาง หรือ เคอร์เนล (Kernel) :

Kernel เป็นส่วนที่สำคัญที่สุดของระบบปฏิบัติการ เพราะมันทำหน้าที่จัดการการเข้าถึงทรัพยากรพื้นฐานของคอมพิวเตอร์ เช่น การจัดการหน่วยประมวลผลกลาง (CPU), หน่วยความจำ (RAM), และอุปกรณ์ที่เชื่อมต่อกับเครื่องต่างๆ (เช่น ฮาร์ดดิสก์, คีย์บอร์ด, จอภาพ) Kernelทำหน้าที่เป็นตัวกลางระหว่างโปรแกรมที่ทำงานและฮาร์ดแวร์ของระบบ โดยมันจะรับคำสั่งจากแอปพลิเคชันและจัดการการประมวลผลหรือทรัพยากรที่ต้องใช้เพื่อให้โปรแกรมนั้นทำงานได้

⦿ ส่วนจัดการหน่วยความจำ (Memory Management)

ทำหน้าที่ในการควบคุมและจัดสรรพื้นที่ในหน่วยความจำ (RAM) ให้กับโปรแกรมที่กำลังทำงาน รวมถึงการจัดการการคืนพื้นที่หน่วยความจำเมื่อโปรแกรมเสร็จสิ้นการทำงาน การจัดการหน่วยความจำมีความสำคัญในการทำให้การทำงานของระบบสมองกลมีประสิทธิภาพและช่วยป้องกันปัญหาการใช้หน่วยความจำซ้ำซ้อนหรือการรั่วไหลของหน่วยความจำ

⦿ ส่วนจัดการกระบวนการ (Process Management)

ทำหน้าที่ในการควบคุมการทำงานของโปรแกรมหรือกระบวนการที่กำลังรันในระบบ การจัดการกระบวนการรวมถึงการกำหนดการใช้ทรัพยากรของแต่ละโปรแกรม เช่น CPU, หน่วยความจำ และการควบคุมการทำงานแบบหลายกระบวนการ (Multitasking) ระบบปฏิบัติการต้องสามารถจัดสรรทรัพยากรให้กับกระบวนการต่างๆ ที่ทำงานพร้อมกันได้อย่างมีประสิทธิภาพ และสามารถสลับการทำงานระหว่างกระบวนการได้อย่างรวดเร็ว

⦿ ส่วนจัดการไฟล์ (File Management)

ทำหน้าที่ในการจัดการไฟล์และโครงสร้างการเก็บข้อมูลในระบบคอมพิวเตอร์ การจัดการไฟล์ช่วยให้ผู้ใช้สามารถสร้าง, อ่าน, แก้ไข, และลบไฟล์ได้ รวมถึงการจัดการโครงสร้างของไดเรกทอรี (Directory) และการควบคุมการเข้าถึงไฟล์เพื่อให้แน่ใจว่าผู้ใช้หรือโปรแกรมที่มีสิทธิ์เท่านั้นที่สามารถเข้าถึงไฟล์นั้นได้

⦿ ส่วนการจัดการอุปกรณ์ (Device Management)

ทำหน้าที่ในการควบคุมและจัดการอุปกรณ์ภายนอกที่เชื่อมต่อกับคอมพิวเตอร์ เช่น คีย์บอร์ด, เมาส์, จอภาพ, และเครื่องพิมพ์ ระบบปฏิบัติการจะใช้ตัวขับ (Driver) ในการสื่อสารกับอุปกรณ์เหล่านี้และจัดการการใช้งานให้มีประสิทธิภาพ

⦿ ส่วนจัดการอินพุต/เอาท์พุต (Input/Output Management)

รับผิดชอบในการจัดการการสื่อสารระหว่างโปรแกรมและอุปกรณ์อินพุต/เอาท์พุต เช่น การอ่านข้อมูลจากแป้นพิมพ์ หรือการแสดงผลข้อมูลบนจอภาพ ระบบปฏิบัติการช่วยให้การทำงานกับอุปกรณ์เหล่านี้เป็นไปอย่างราบรื่น โดยไม่ต้องให้ผู้ใช้หรือโปรแกรมทำการจัดการโดยตรง

⦿ ส่วนรักษาความปลอดภัย (Security Management) :

ระบบปฏิบัติการต้องมีระบบในการรักษาความปลอดภัยของข้อมูลและทรัพยากรในระบบ เช่น การควบคุมการเข้าถึงไฟล์และโปรแกรม, การตรวจสอบสิทธิ์การใช้งาน, การป้องกันการโจมตีจากภายนอก เช่น ไวรัส และการจัดการข้อมูลที่สำคัญให้ได้รับการปกป้อง

⦿ ส่วนอินเตอร์เฟซผู้ใช้ (User Interface) :

ระบบปฏิบัติการมีการจัดเตรียมอินเตอร์เฟซที่ช่วยให้ผู้ใช้สามารถโต้ตอบกับระบบได้อย่างสะดวกและง่ายดาย อินเตอร์เฟซนี้อาจจะเป็นแบบกราฟิก (Graphical User Interface: GUI) หรือแบบคำสั่ง (Command Line Interface: CLI) ขึ้นอยู่กับลักษณะการใช้งานของระบบและผู้ใช้

⦿ การจัดการเครือข่าย (Network Management) :

หากระบบสมองกลเชื่อมต่อกับเครือข่าย เช่น อินเทอร์เน็ตหรือเครือข่ายภายใน ระบบปฏิบัติการต้องมีการจัดการการเชื่อมต่อเครือข่ายและการสื่อสารระหว่างเครื่องคอมพิวเตอร์ต่างๆ เพื่อให้การส่งข้อมูลและการติดต่อระหว่างเครื่องทำได้อย่างมีประสิทธิภาพ

ส่วนประกอบเหล่านี้ทำงานร่วมกันภายในระบบปฏิบัติการเพื่อให้สามารถควบคุมและจัดการการทำงานของระบบสมองกลได้อย่างมีประสิทธิภาพ ช่วยให้ผู้ใช้สามารถใช้งานแอปพลิเคชันต่างๆ ได้อย่างสะดวกและรวดเร็ว โดยที่ไม่ต้องกังวลเกี่ยวกับการจัดการทรัพยากรหรือฮาร์ดแวร์ของเครื่องเอง

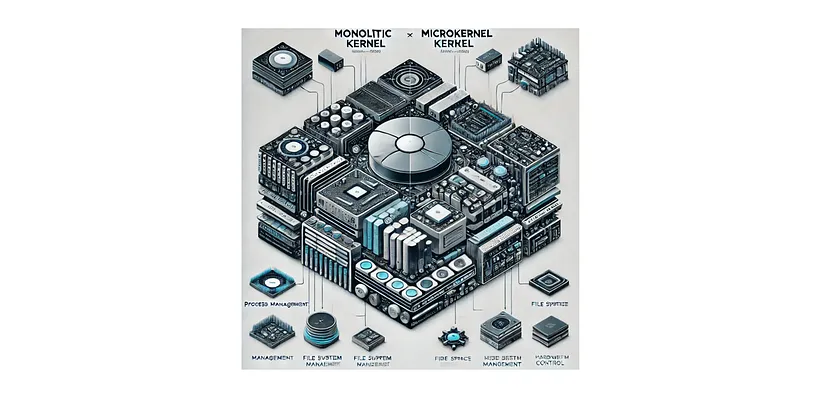

สถาปัตยกรรมของ Kernel

Monolithic Kernel และ Microkernel เป็นสองสถาปัตยกรรมของระบบปฏิบัติการที่มีแนวทางในการจัดการการทำงานของเคอร์เนลแตกต่างกัน ทั้งสองแบบมีข้อดีและข้อเสียที่เหมาะสมกับการใช้งานในสถานการณ์ที่แตกต่างกัน

🌠 Monolithic Kernel

เป็นสถาปัตยกรรมที่เคอร์เนลจะทำงานทั้งหมดในพื้นที่เดียวกันโดยไม่แยกออกเป็นส่วนๆ ระหว่าง user space และ kernel space ซึ่งหมายความว่าเคอร์เนลจะรับผิดชอบทั้งในเรื่องของการจัดการกระบวนการ (process management), การจัดการหน่วยความจำ (memory management), การจัดการไฟล์ (file system management), และการควบคุมการเข้าถึงฮาร์ดแวร์โดยตรง ทุกๆ ฟังก์ชันที่เกี่ยวข้องกับการทำงานของระบบปฏิบัติการจะถูกรวมไว้ใน kernel space ซึ่งทำให้การสื่อสารระหว่างฟังก์ชันต่างๆ ทำได้อย่างรวดเร็วและมีประสิทธิภาพ เพราะทุกอย่างทำงานในหน่วยความจำเดียวกัน ทำให้ไม่ต้องมีการสื่อสารข้ามระหว่างพื้นที่ต่างๆ ที่อาจทำให้เสียเวลาและประสิทธิภาพในการทำงานลงไป

ความเร็วในการทำงานของ Monolithic Kernel มาจากการที่ทุกๆ ฟังก์ชันสามารถทำงานได้อย่างมีประสิทธิภาพ เนื่องจากการเข้าถึงฮาร์ดแวร์ต่างๆ สามารถทำได้โดยตรงและรวดเร็วจากภายในเคอร์เนลเอง เช่น การเข้าถึงอุปกรณ์เก็บข้อมูลหรือการจัดการระบบเครือข่ายสามารถทำได้อย่างตรงไปตรงมา การทำงานของระบบปฏิบัติการจะไม่มีช่องว่างในการทำงาน เนื่องจากฟังก์ชันทั้งหมดทำงานร่วมกันในที่เดียวกัน ซึ่งทำให้การประมวลผลและการตอบสนองต่อคำสั่งมีความรวดเร็วและไม่มีการขัดจังหวะจากฟังก์ชันอื่นๆ ที่ทำงานในที่แยกต่างหาก

ตัวอย่างที่ใช้ Monolithic Kernel ได้แก่ Linux Kernel, ซึ่งเป็นเคอร์เนลที่ใช้ในหลายๆ ระบบปฏิบัติการเช่น Android OS และบางเวอร์ชันของ Windows NT ซึ่งเป็นการนำเคอร์เนลแบบโมโนลิธิคมาใช้ในการควบคุมการทำงานภายในระบบ

แต่ในขณะที่ Monolithic Kernel มีข้อดีในด้านประสิทธิภาพและความเร็วในการทำงาน ก็ยังมีข้อเสียที่สำคัญ ซึ่งหนึ่งในนั้นคือ ความเสี่ยงสูง หากมีข้อผิดพลาดเกิดขึ้นในส่วนใดของเคอร์เนล ก็อาจจะทำให้ระบบล่มทั้งหมดได้ เนื่องจากทุกฟังก์ชันอยู่ในที่เดียวกัน การแยกฟังก์ชันออกเป็นส่วนๆ ก็ทำได้ยาก ทำให้การขยายและการเพิ่มฟังก์ชันใหม่ๆ หรือการปรับปรุงระบบอาจทำได้ยากเนื่องจากทุกอย่างต้องทำงานในเคอร์เนลเดียวกัน ข้อเสียอีกข้อคือ การบำรุงรักษา เนื่องจากเคอร์เนลที่มีขนาดใหญ่และรวมฟังก์ชันทั้งหมดไว้ในที่เดียวกัน อาจทำให้การตรวจสอบและการแก้ไขปัญหาทำได้ยากและซับซ้อน

🌠 Microkernel

Microkernel เป็นสถาปัตยกรรมที่ออกแบบเคอร์เนลให้มีขนาดเล็กและเบา โดยแยกฟังก์ชันต่างๆ ที่ไม่จำเป็นต้องทำงานในพื้นที่ของเคอร์เนลออกไปทำงานใน user space (พื้นที่ผู้ใช้) ซึ่งฟังก์ชันที่ทำงานใน kernel space จะจำกัดแค่ฟังก์ชันพื้นฐานที่จำเป็นเท่านั้น เช่น การจัดการกระบวนการ (process management), การสื่อสารระหว่างโปรเซส (Inter-process Communication หรือ IPC), การจัดการข้อผิดพลาด (error handling), และการควบคุมการเข้าถึงฮาร์ดแวร์ที่สำคัญ (hardware abstraction) ฟังก์ชันอื่นๆ เช่น การจัดการไฟล์, การจัดการอุปกรณ์, และบริการต่างๆ จะถูกรันในรูปแบบของโปรเซสแยกต่างหากใน user space โดยไม่ขึ้นกับเคอร์เนลหลัก

การแยกการทำงานของระบบออกเป็นหลายๆ โปรเซสทำให้ระบบมีความยืดหยุ่นสูง สามารถปรับปรุงหรือเปลี่ยนแปลงฟังก์ชันการทำงานต่างๆ ได้ง่ายขึ้นโดยไม่ต้องแก้ไขส่วนหลักของเคอร์เนล การบำรุงรักษาจึงง่ายและมีความเสถียรมากขึ้น เนื่องจากข้อผิดพลาดที่เกิดขึ้นในฟังก์ชันที่ทำงานใน user space จะไม่กระทบต่อการทำงานของเคอร์เนลหรือระบบทั้งหมด ซึ่งช่วยเพิ่มความปลอดภัยให้กับระบบโดยรวม เมื่อฟังก์ชันที่ไม่เกี่ยวข้องกับการทำงานพื้นฐานของระบบถูกแยกออกไป

การออกแบบแบบนี้ช่วยให้การติดตั้งหรืออัปเดตบริการใหม่ๆ สามารถทำได้ง่าย เพราะไม่จำเป็นต้องมีการปรับเปลี่ยนโค้ดของเคอร์เนลหลักเลย เช่น การเพิ่มไดรเวอร์ใหม่ๆ หรือการเพิ่มฟังก์ชันใหม่ๆ ในระบบปฏิบัติการก็สามารถทำได้โดยการเพิ่มโปรเซสใน user space ที่สามารถทำงานแยกต่างหากได้โดยไม่กระทบกับระบบหลักของเคอร์เนล

อย่างไรก็ตาม ข้อเสียของ Microkernel คือ ค่าใช้จ่ายด้านประสิทธิภาพ ซึ่งเกิดจากการสื่อสารระหว่าง user space และ kernel space ผ่านการสื่อสารระหว่างโปรเซส (IPC) ซึ่งต้องใช้เวลามากกว่าการทำงานใน Monolithic Kernel ที่ทุกฟังก์ชันอยู่ในพื้นที่เดียวกัน ดังนั้นการสื่อสารข้ามขอบเขตระหว่างพื้นที่ต่างๆ จึงอาจทำให้การดำเนินการช้าลง และการสื่อสารเหล่านี้อาจกลายเป็นจุดแคบ (bottleneck) ในระบบที่มีภาระงานสูง

อีกข้อที่เป็น ข้อเสีย ของ Microkernel คือ ซับซ้อนในการออกแบบ เพราะการแยกฟังก์ชันต่างๆ ออกเป็นโปรเซสหลายตัว ทำให้ต้องมีการจัดการการสื่อสารระหว่างโปรเซสอย่างละเอียดและมีการจัดการความสอดคล้องของข้อมูลที่ระหว่าง kernel space และ user space ซึ่งอาจทำให้การออกแบบระบบที่ใช้งานได้อย่างมีประสิทธิภาพนั้นซับซ้อนและยากขึ้น

ตัวอย่างของ Microkernel ที่ใช้งานในระบบต่างๆ ได้แก่ Mach Kernel ที่ใช้ใน Mac OS X (และระบบปฏิบัติการอื่นๆ ที่เกี่ยวข้องกับ Unix), MINIX ซึ่งเป็นระบบที่ใช้เพื่อการศึกษาหลักการของ Microkernel, QNX ซึ่งเป็นระบบปฏิบัติการที่ใช้ในอุตสาหกรรม เช่น การควบคุมในรถยนต์หรืออุปกรณ์ทางการแพทย์, และ L4 Microkernel ที่เป็นที่รู้จักในระบบที่ต้องการความปลอดภัยและประสิทธิภาพสูง

“ Animam dimitte, clades ne timeas,

Discere ex errore, iter non desinas ”

“ Release the mind, fear not defeat,

Learn from the fall, and rise on your feet ”

“ ปล่อยจิตหยุดจดจ่อ ไม่ท้อถอยเพราะพ่ายแพ้ แต่ถือเป็นบทเรียน อย่างนั้นแล้ว ก้าวย่างต่อไปย่อมยากจักเพลี่ยงพล้ำ ”

Naturvirtus

XX Ianuarius MMXXV